所有語言

分享

關於生成式 AI 的六個懸而未決的問題及預測

文章來源:麻省理工科技評論

作者:Will Douglas Heaven

生成式人工智能在 2023 年席捲全球。它的未來以及我們的未來將取決於我們下一步的行動。

圖片來源:由無界 AI生成

從很多方面來看,目前圍繞生成式人工智能的熱議都讓人想起互聯網的早期階段:人們感到興奮和期待,而且還有一種正在不斷創造的感覺。

可以這麼說,我們正處於 2000 年左右的互聯網繁榮時期。很多公司會倒閉。我們可能需要幾年時間才能看到這個時代的 Facebook(現在是 Meta)、Twitter(現在是 X)或 TikTok 出現。技術諮詢公司 Booz Allen Hamilton 生成式人工智能主管 Alison Smith 說:“人們不願意想象 10 年後的未來,因為誰也不想顯得愚蠢。”“但我認為,它將會大大超出我們的預期。”

互聯網改變了一切 -- 我們如何工作和娛樂、如何與朋友和家人共度時光、如何學習、如何消費、如何戀愛,等等。但它也給我們帶來了網絡欺凌、報復性色情和巨魔工廠。它助長了種族滅絕,加劇了心理健康危機,並使監控資本主義 -- 其令人上癮的算法和掠奪性廣告 -- 成為我們這個時代的主導市場力量。只有當人們開始大量使用人工智能,社交媒體等殺手級應用出現時,這些弊端才會顯現出來。

生成式人工智能很可能也是如此。有了基礎架構 -- 來自 OpenAI、谷歌、Meta 和其他少數幾家公司的基礎生成模型 -- 除了構建者之外,其他人也會開始以其製造者做夢也想不到的方式使用和濫用它。Smith 說:“如果沒有個人用戶的真正使用,我們就無法充分了解它的潛力和風險。”

生成式人工智能是在互聯網上訓練出來的,因此繼承了互聯網上許多尚未解決的問題,包括與偏見、錯誤信息、侵犯版權、踐踏人權和全面經濟動蕩有關的問題。所以,我們決不能盲目行動。

在我們觀察生成式人工智能革命的發展過程中,有六個懸而未決的問題值得注意。這一次,我們有機會做得更好。

1. 我們能減輕偏見問題嗎?

偏見已成為人工智能相關危害的代名詞。現實世界的數據,尤其是從互聯網上搜索到的文本和圖片,充滿了偏見,從性別刻板印象到種族歧視,不一而足。在這些數據上訓練出來的模型會對這些偏見進行編碼,然後在使用它們的地方強化這些偏見。

聊天機器人和圖像生成器傾向於將工程師描繪成白人和男性,將護士描繪成白人和女性。黑人有可能被警察部門的面部識別程序誤認,從而導致錯誤逮捕。招聘算法也更傾向於男性而不是女性。

如果沒有新的數據集或新的模型訓練方法(這兩項工作都需要數年時間),偏見問題的根源就會一直存在。但這並不妨礙它成為一個熱門的研究課題。OpenAI 一直致力於利用人類反饋強化學習(RLHF)等技術來減少大型語言模型的偏差。這將引導模型的輸出向人類測試者認為他們更喜歡的文本類型靠攏。

其他技術包括使用合成數據集。例如,Runway 在人工智能生成的不同種族、性別、職業和年齡的人的圖像等合成數據上訓練了一個版本的 Stable Diffusion。該公司報告說,在該數據集上訓練的模型生成了更多膚色較深的人的圖像和更多女性的圖像。如果需要一張商務人士的圖像,那麼輸出的圖像也會出現戴頭巾的女性;醫生的圖像也會出現不同膚色和性別的人,等等。

然而,一些批評者認為,這些解決方案只是在破損的基礎模型上貼創可貼,掩蓋而非解決問題。但 Smith 在 Booz Allen Hamilton 的同事、該公司負責人工智能的主管 Geoff Schaefer 認為,從長遠來看,這種算法偏見可以暴露社會偏見。

舉例來說,他指出,即使從數據集中刪除了明確的種族信息,種族偏見仍然會影響數據驅動的決策,因為種族可以從人們的地址中推斷出來,從而揭示出種族隔離和住房歧視的模式。他說:“我們把大量數據集中在一起,這種相關性就變得非常明顯了。”

Schaefer 認為,這一代人工智能也會發生類似的事情:“全社會的這些偏見都會顯現出來。“他說,這將導致更有針對性的政策制定。

然而,很多人會對這種樂觀態度表示反對。問題暴露在公眾面前並不能保證它一定會得到解決。政策制定者仍在努力解決多年前就暴露出來的社會偏見,包括住房、招聘、貸款、治安等方面。與此同時,個人也要承擔後果。

預測:偏見仍將是大多數人工智能生成模型的固有特徵。但變通方法和不斷提高的意識可以幫助決策者解決最明顯的例子。

2. AI 將如何改變應用版權的方式?

藝術家和作家(以及程序員)對科技公司未經同意就從他們的作品中獲利感到憤怒,因此對 OpenAI、微軟和其他公司提起了集體訴訟,聲稱它們侵犯了版權。Getty 正在起訴 Stable Diffusion 背後的公司 Stability AI。

這些案件都是大事。Sarah Silverman 和 George R.R. Martin 等知名人士引起了媒體的關注。至少在美國,這些案件將改寫有關合理使用和不合理使用他人作品的規則。

然而,這一切還不會立馬有結果。代表 280 多家人工智能公司的 Gunderson Dettmer 律師事務所專門從事知識產權許可的合伙人 Katie Gardner 說,法院做出最終裁決還需要好幾年的時間。她說:“到那時,這項技術將在經濟中根深蒂固,無法挽回。”

與此同時,科技行業正以驚人的速度在這些涉嫌侵權行為的基礎上繼續發展。Gardner 說:“我不認為公司會觀望。”“可能會有一些法律風險,但如果跟不上,還有很多其他風險。”

一些公司已經採取措施限制侵權的可能性。OpenAI 和 Meta 聲稱,它們已經為創作者提供了從未來數據集中刪除作品的方法。現在,OpenAI 也禁止 DALL-E 的用戶要求獲得在世藝術家風格的圖像。但是,Gardner 說:“這些都是為了支持他們在訴訟中的論點而採取的行動”。

谷歌、微軟和 OpenAI 現在都提出要保護其模型的用戶免受潛在的法律訴訟。微軟為其生成式編碼助手 GitHub Copilot 制定的賠償政策,原則上將在法院解決此事時保護那些使用該軟件的用戶。微軟首席執行官 Satya Nadella 表示:“我們將承擔這一責任,讓我們產品的用戶不必為此擔心。”

與此同時,新的授權協議也層出不窮。Shutterstock 已與 OpenAI 簽署了一份為期六年的協議,以使用其圖像。Adobe 聲稱其自己的圖像製作模型 Firefly 只接受了許可圖像、Adobe Stock 數據集中的圖像或不再受版權保護的圖像的訓練。不過,Adobe Stock 的一些貢獻者表示,他們沒有被徵求過意見,而且對此並不滿意。

怨恨情緒十分強烈。現在,藝術家們正在用自己的技術進行反擊。一款名為“Nightshade”的工具可以讓用戶以人類無法察覺的方式修改圖片,但對機器學習模型來說卻是毀滅性的,它會讓模型在訓練過程中對圖片進行錯誤分類。網絡媒體的共享和再利用規範有望發生重大調整。

預測:高調的訴訟將繼續吸引人們的關注,但這不可能阻止公司建立生成模型。圍繞道德數據集的新市場將會興起,公司與創作者之間的貓鼠遊戲將會繼續上演。

3. AI 將如何改變工作?

我們早就聽說人工智能正在取代我們的工作。這次的一個不同之處在於,白領 -- 數據分析師、醫生、律師和記者 -- 看起來也面臨風險。聊天機器人可以應對高中考試、專業醫療執照考試和律師資格考試。它們還能總結會議內容,甚至撰寫基本的新聞報道。那麼,留給我們的工作還有什麼?事實遠非如此簡單。

許多研究人員否認大型語言模型的表現是真正智能的證據。但即便如此,對於大多數專業角色來說,這些模型所能完成的任務還遠遠不止這些。

去年夏天,賓夕法尼亞大學沃頓商學院研究創新的 Ethan Mollick 幫助波士頓諮詢集團進行了一項實驗,研究 ChatGPT 對顧問的影響。該團隊給數百名顧問布置了 18 項與一家虛構的製鞋公司有關的任務,如“針對服務不足的市場或運動提出至少 10 個新鞋創意”以及“根據用戶劃分製鞋業市場”。小組中有些人使用了 ChatGPT,也有人沒用。

實驗的結果令人震驚:“使用 ChatGPT-4 的顧問在各方面的表現都遠遠優於未使用 ChatGPT-4 的顧問。在每個維度上都是如此。”Mollick 在一篇關於這項研究的博文中寫道。

風險投資公司 Air Street Capital 的創始人兼《人工智能現狀報告》(State of AI Report)團隊負責人 Nathan Benaich 說,許多企業已經在使用大型語言模型來查找和獲取信息。對此他表示歡迎:“希望分析師能夠成為一種人工智能模型,”他說。“這些東西基本上都是令人頭疼的。”

他的觀點是,將繁重的工作交給機器,可以讓人們專註於工作中更有意義的部分。這種技術似乎還能提高員工的技能:早期的研究,比如 Mollick 對顧問和其他編碼員的研究表明,經驗較少的人在使用人工智能後會得到更大的提升。(不過也有一些注意事項。Mollick 發現,過於依賴 GPT-4 的人變得粗心大意,當模型出錯時,他們不太可能發現錯誤)。

生成式 AI 不僅能改變上述工作。圖像和視頻製作模型可以在沒有人類插畫師、攝影師或演員的情況下,製作出無窮無盡的圖片和電影。2023 年美國編劇和演員的罷工表明,這將是未來幾年的一個熱點。

即便如此,許多研究人員認為這項技術總體上是提高工人的能力,而不是取代工人。畢竟,自工業革命以來,技術一直在為工作而生。隨着舊的工作崗位逐漸消失,新的工作崗位也隨之產生。Smith 說:“我強烈地感覺到,這是一種凈积極因素。”

然而,變革總是痛苦的,凈收益可能掩蓋個別損失。技術變革也往往會集中財富和權力,加劇不平等。

Mollick 寫道:“在我看來,問題不再是人工智能是否會重塑工作,而是我們希望這意味着什麼。”

預測:對大量失業的擔憂將被誇大。但生成工具將繼續在工作場所大量出現。角色可能會改變;我們可能需要學習新的技能。

4. AI 會帶來哪些錯誤信息?

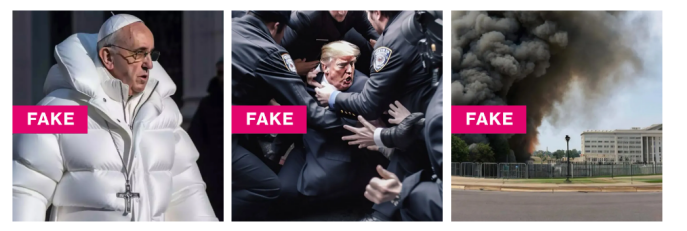

2023 年最熱門的三張圖片分別是教皇身穿 Balenciaga、特朗普被警察摔倒在地以及五角大樓爆炸的照片。所有這些都是假的,但都被數百萬人看到並分享。

使用生成模型創建虛假文本或圖像比以往任何時候都要容易。許多人警告說,錯誤信息將過載。OpenAI 合作開展了一項研究,強調了其技術在假新聞活動中的許多潛在濫用。在 2023 年的一份報告中,它警告說,大型語言模型可用於大規模製作更具說服力的宣傳品,而這種宣傳很難被發現。美國和歐盟的專家已經表示選舉面臨風險。

拜登政府將人工智能生成內容的標籤和檢測作為其 10 月份人工智能行政令的重點,這並不令人意外。但該命令並沒有從法律上要求工具製造商將文本或圖像標註為人工智能的作品。而最好的檢測工具也還沒有好到可以信賴的程度。

本月達成一致的歐盟人工智能法案則更進一步。該法案的部分內容要求公司在人工智能生成的文本、圖像或視頻上打上水印,並向人們明確說明他們是在與聊天機器人互動。此外,《人工智能法案》還具有法律效力:這些規則將具有約束力,並對違規行為處以高額罰款。

美國還表示,它將對任何可能對國家安全構成威脅的人工智能進行審計,包括干預選舉。Benaich 將這稱之為偉大的進步。但是,即使是這些模型的開發者也不知道它們的全部能力:“政府或其他獨立機構可以強迫公司在發布模型之前對其進行全面測試,這種想法似乎並不現實”。

問題在於:在一項技術被使用之前,我們不可能知道它被濫用的所有方式。“2023 年,有很多關於放慢人工智能發展速度的討論,”Schaefer 說。“但我們持相反的觀點。”

除非這些工具被盡可能多的人以盡可能多的不同方式使用,否則我們不會讓它們變得更好。他說:”我們不會了解這些怪異風險的細微表現方式,也不會了解哪些事件會觸發這些風險。“

預測:隨着使用的增加,新的濫用形式將不斷出現。會有一些突出的例子,比如涉及選舉操縱。

5. 我們能否接受 AI 的成本?

生成式人工智能的開發成本,包括人力成本和環境成本,也需要加以考慮。隱形工人問題是一個公開的秘密:我們之所以能倖免於生成模型所能產生的最糟糕的結果,部分原因在於有大量隱蔽的(通常收入微薄的)工人為訓練數據貼標籤,並在測試過程中剔除有毒的、有時是創傷性的輸出結果。這是數據時代的血汗工廠。

2023 年,OpenAI 在肯尼亞使用工人的做法受到了《時代》和《華爾街日報》等大眾媒體的關注。OpenAI 希望通過建立一個過濾器來改進其生成模型,從而從用戶那裡隱藏仇恨、淫穢和其他令人反感的內容。但要做到這一點,它需要人們發現並標註大量此類有毒內容的例子,以便其自動過濾器能夠學會識別它們。OpenAI 僱用了外包公司 Sama,而後者則被指控在肯尼亞使用了低薪工人,這些工人幾乎得不到任何報酬。

隨着生成式人工智能成為主流關注點,人力成本將成為更突出的焦點,這將給建立這些模型的公司帶來壓力,要求它們解決世界各地受雇幫助改進其技術的工人的勞動條件問題。

另一個巨大的成本,即訓練大型生成模型所需的能源,在情況好轉之前還將繼續攀升。今年 8 月,英偉達宣布 2024 年第二季度盈利超過 135 億美元,是上年同期的兩倍。其中大部分收入(103 億美元)來自數據中心,換句話說,就是使用 英偉達硬件訓練人工智能模型的其他公司。

英偉達首席執行官黃仁勛(Jensen Huang)表示:“需求非常大。”“我們正處於生成式人工智能的起飛階段。”他承認存在能源問題,並預測這一熱潮甚至會推動所部署的計算硬件類型發生變化。他說:“世界上絕大多數計算基礎設施都必須高效節能。”

預測:公眾對人工智能的勞動力和環境成本的認識提高,將給科技公司帶來壓力。但不要指望這兩方面很快會有明顯改善。

6. 末日論會繼續主導決策嗎?

長期以來,人工智能領域一直暗流涌動,人們擔心智能機器的誕生會帶來災難性的後果,甚至是世界末日。由於炒作達到了頂峰,再加上人工智能先驅 Geoffrey Hinton 在 5 月份高調宣布對自己幫助建立的技術感到恐懼,使得這種情緒浮出水面。

在 2023 年,幾乎沒有什麼問題能像這個問題一樣引發分歧。像辛頓和同為圖靈獎獲得者的 Yann LeCun 這樣的人工智能名人都在公開場合大打口水仗,在社交媒體上互相攻擊。

辛頓、OpenAI 首席執行官山姆 - 阿爾特曼(Sam Altman)等人建議,(未來的)人工智能系統應該有類似於核武器的保障措施。這些言論引起了人們的關注。但美國科學家聯合會(Federation of American Scientists)核信息項目經理 Matt Korda 在今年七月與他人合寫的一篇文章中,對這些“混淆不清的類比”及其引發的“媒體恐慌”表示譴責。

Benaich 說,我們很難理解什麼是真實的,什麼是虛假的,因為我們不知道發出警報的人的動機是什麼。“很多人因為這些東西而變得非常富有,而很多人正是那些要求加強控制的人,這看起來確實很奇怪。這就好像,‘嘿,我發明了一種非常強大的東西!它有很多風險,但我有解藥’”。

有些人擔心所有這些恐懼宣傳的影響。深度學習先驅 Andrew Ng 在 X 上寫道:“我對人工智能未來最擔心的是,如果過度誇大的風險(比如人類滅絕)讓科技遊說者頒布了壓制開源和壓制創新的窒息性法規。”這場爭論還將資源和研究人員從更直接的風險上引開,如偏見、工作動蕩和錯誤信息。

谷歌頗具影響力的人工智能研究員 François Chollet 表示:“有些人推崇存在性風險,因為他們認為這對自己的公司有利,”“談論生存風險既能凸顯你的道德意識和責任感,又能轉移人們對更現實、更緊迫問題的注意力。”

Benaich 指出,有些人一方面敲響警鐘,另一方面卻在為自己的公司籌集 1 億美元的資金。他說:“大可以說‘末日論’是一種籌資策略。”

預測:恐慌會逐漸平息,但對決策者議程的影響可能會持續一段時間。呼籲重新關注更直接危害的呼聲將會繼續。

仍然缺失:人工智能的殺手級應用

想想 ChatGPT 差點就沒出現。在 2022 年 11 月推出之前,OpenAI 的聯合創始人兼首席科學家 Ilya Sutskever 並不看好 ChatGPT 的準確性。公司里的其他人也擔心它並沒有什麼進步。從本質上講,ChatGPT 更像是混搭,而不是革命。它由 GPT-3.5 驅動,這是 OpenAI 幾個月前開發的大型語言模型。但是,聊天機器人將一些引人入勝的調整 -- 尤其是更會說話、更有針對性的回復 -- 整合到了一個易於使用的軟件包中。“它功能強大且方便,”Sutskever 說。“這是人工智能領域第一次讓人工智能之外的人看到人工智能的進步。”

ChatGPT 引發的熱潮還沒有結束。Sutskever 說:“人工智能是城裡唯一的遊戲。”“這是科技領域最大的事情,而科技是經濟領域最大的事情。我認為,我們將繼續為人工智能所能做的事情感到驚訝。”

不過,既然我們已經看到了人工智能的能耐,也許眼下的問題是它的用途。OpenAI 在構建這項技術時並沒有考慮到它的真正用途。研究人員在發布 ChatGPT 時似乎是這麼說的:想怎麼用就怎麼用。從那時起,每個人都在爭先恐后地尋找答案。

“我發現 ChatGPT 非常有用,”Sutskever 說。“我經常用它來做各種亂七八糟的事情。”他說,他用它來查找某些單詞,或者幫助他更清楚地表達自己的意思。有時,他還會用它來查找事實(儘管並不總是事實)。OpenAI 的其他人則用它來制定度假計劃,或者提供編碼技巧或 IT 支持。

這些都很有用,但不能改變遊戲規則。這些例子中的大多數都可以用現有的工具來完成,比如搜索。與此同時,據說谷歌內部員工對該公司自己的聊天機器人巴德(Bard)(現在由谷歌的 GPT-4 競爭對手 Gemini 提供支持,於上個月推出)的實用性表示懷疑。“我仍在思考的最大挑戰是:就幫助性而言,LLM 真正有用的是什麼?”據彭博社報道,Bard 的用戶體驗負責人 Cathy Pearl 今年 8 月在 Discord 上寫道。“比如真正有所作為。待定!”

沒有殺手級應用,“wow”的效應就會逐漸消失。投資公司紅杉資本(Sequoia Capital)的統計數據显示,儘管 ChatGPT、Character.ai 和 Lensa 等人工智能應用推出時病毒式傳播,但這些應用的用戶流失速度比 YouTube、Instagram 和 TikTok 等現有流行服務更快。

Benaich 說:“消費科技的法則依然適用。”“會有很多實驗,很多東西在炒作幾個月後就會死掉。”

當然,互聯網的早期也充滿了錯誤的開始。在改變世界之前,網絡公司的繁榮以失敗告終。今天的生成式人工智能總是有可能消聲匿跡,被下一個大事件所取代。

不管發生什麼,既然人工智能已經完全成為主流,那麼利基問題就成了所有人的問題。正如 Schaefer 所說:“我們將被迫以前所未有的方式來解決這些問題。”