所有語言

分享

OpenAI 團隊發布 GPT-4 的最新用法,打造內容審核系統,減少人工參与

圖片來源:由無界 AI 生成

8 月 16 日,OpenAI 團隊發布了一種新的 AI 用途,即使用 GPT-4 進行內容政策制定和內容審核決策,從而實現更一致的標籤、更快的政策細化反饋循環,並減少人工審核者的參与。

內容審核在維持数字平台的健康發展方面發揮着至關重要的作用。 OpenAI 研究人員發現使用 GPT-4 的內容審核系統可以更快地迭代策略更改,將周期從幾個月縮短到幾個小時。

同時,GPT-4 還能夠解釋長內容策略文檔中的規則和細微差別,並立即適應策略更新,從而產生更一致的標籤。 這為数字平台的未來提供了更积極的願景,AI 可以根據平台特定的政策幫助調節在線流量,並減輕大量人類調節者的身體和精神負擔。

哪類用戶可用:任何擁有 OpenAI API 訪問權限的人都可以實施這種方法來創建自己的 AI 輔助審核系統。

內容審核方面面臨的挑戰

內容審核需要細緻的努力、敏感性、對背景的深刻理解以及對新用例的快速適應,這使得這個流程既耗時又具有挑戰性。 傳統上,這項任務的負擔落在了人類管理者身上,他們在較小的垂直特定機器學習模型的支持下,篩選大量內容以過濾掉有毒有害材料。 這個過程本質上是緩慢的,並且可能會給人類帶來精神壓力。

使用大型語言模型(LLM)解決

OpenAI 研究團隊正在探索利用 LLM 來應對這些挑戰。 他們認為其大型語言模型(例如 GPT-4)可以理解並生成自然語言,使其適用於內容審核。 這些模型可以根據提供給他們的政策指南做出適度判斷。

藉助該系統,開發和定製內容審核策略的過程從幾個月縮短到幾個小時。

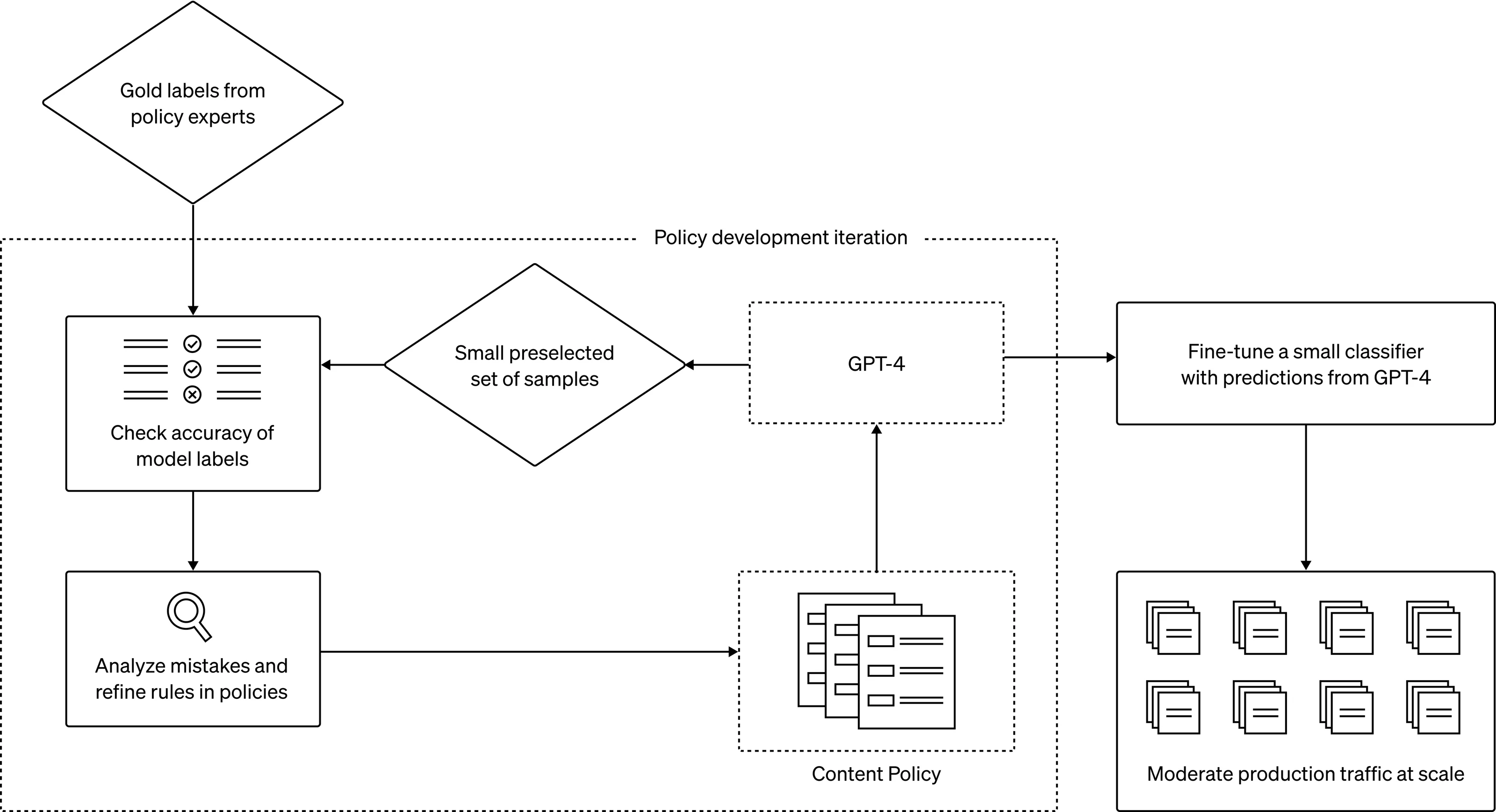

- 一旦制定了審核政策指南,政策專家就可以通過識別少量示例並根據政策為其分配標籤來創建一組黃金數據。

- 然後,GPT-4 讀取策略並將標籤分配給同一數據集,但不會看到答案。

- 通過檢查 GPT-4 的判斷與人類判斷之間的差異,政策專家可以要求 GPT-4 提出其標籤背後的推理,分析政策定義中的模糊性,解決混亂並相應地在政策中提供進一步的澄清。 我們可以重複步驟 2 和 3,直到我們對策略質量感到滿意為止。

這個迭代過程產生了細化的內容策略,這些策略被轉換為分類器,從而能夠大規模部署策略和內容審核。

或者,為了大規模處理大量數據,我們可以使用 GPT-4 的預測來微調出一個更小的模型。

這個簡單而強大的想法為傳統的內容審核方法提供了一些改進:

標籤更加一致。 內容政策不斷髮展並且通常非常詳細。 人們可能會對政策有不同的解釋,或者一些版主可能需要更長的時間來消化新的政策變化,從而導致標籤不一致。 相比之下,法學碩士對措辭的細微差異很敏感,可以立即適應政策更新,為用戶提供一致的內容體驗。

更快的反饋循環。 政策更新的周期——制定新政策、貼標籤和收集人類反饋——往往是一個漫長而漫長的過程。 GPT-4 可以將這一過程縮短至幾個小時,從而能夠更快地響應新的危害。

減輕精神負擔。 持續接觸有害或令人反感的內容可能會導致主持人情緒疲憊和心理壓力。 自動化此類工作有利於相關人員的福祉。

上圖解釋了如何利用 GPT-4 進行內容審核(從政策制定到大規模審核)的過程

與主要依賴於模型自身對安全與不安全的內在判斷的 Constitutional AI 不同,OpenAI 的方法使特定於平台的內容策略迭代更快、更省力。

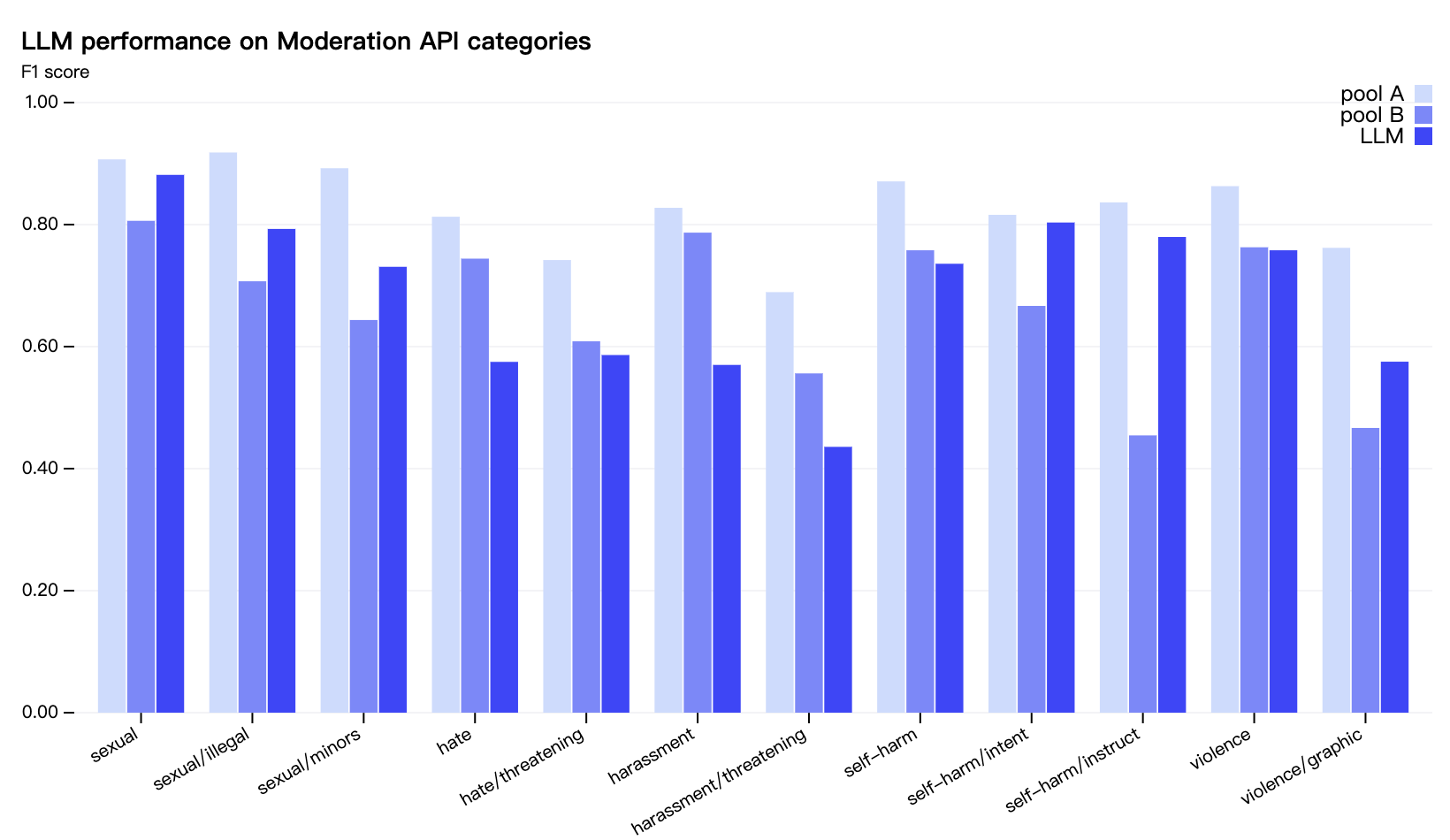

(上圖)GPT-4 的打標質量與經過輕度訓練的人類審核員相似(Pool B)。 然而,經驗豐富、訓練有素的人類主持人(Pool A)的表現仍然優於兩者。

OpenAI 研究團隊正在积極探索進一步提高 GPT-4 的預測質量,例如通過納入鏈式推理或自我批評。 同時還在嘗試檢測未知風險的方法,並受 Constitutional AI 的啟發,旨在利用模型來識別潛在有害內容,並給出對有害內容的高級描述。 然後,這些發現將為現有內容政策的更新或針對全新風險領域的政策的制定提供信息。

注:Constitutional AI 是由 OpenAI 前成員創建的競爭對手 Anthropic 為其大模型產品 Claude 所開發的一種機制,其旨在提供一種「基於原則」的方法使 AI 系統與人類意圖保持一致,讓 ChatGPT 類模型使用一組簡單的原則作為指導來回答問題。