所有語言

分享

人類數據告急,微軟OpenAI開始用AI喂AI,奧特曼放話:未來所有數據都將變成合成數據

原文來源:量子位

圖片來源:由無界 AI 生成

人類數據缺缺缺,AI被迫開始吃AI生產的數據了!

這是微軟、OpenAI等一眾AI前沿公司面臨的現狀。

他們從維基百科、电子書、新聞網站、博客、推特和Reddit等平台和論壇中搜羅了大量數據,然後現在……這些數據快被用完了。

BUT,要訓練更好的大模型,多少數據都不夠。

據《金融時報》介紹,不少公司正把大模型生成的結果、也就是所謂的合成數據(Synthetic data),餵給參數量更小的大模型吃,發現效果還不錯。

對於使用合成數據,OpenAI的CEO Sam Altman不僅不介意,還放話“未來所有數據都將變成合成數據”。

估值20億美元的大模型初創公司Cohere同樣在用合成數據。公司CEO、經典大模型Transformer論文作者之一Aidan Gomez甚至認為:

合成數據可能加速通往“ 超級智能”AI系統的道路。

所以,究竟哪些大模型已經在用合成數據了,這些合成數據又是從何而來?

大AI合成數據,小AI吃

這些所謂的合成數據,本質上是用當前表現較好的大模型生成的數據,經過人工調整后,再餵給稍微小一點的大模型。

例如Cohere公司就嘗試使用了兩個大模型進行“角色扮演”對話,並將它們生成的結果做成合成數據。

這兩個大模型分別扮演“數學老師”和“學生”,正在進行一堂虛擬的數學教學。同時,Cohere安排一個人類員工在旁邊監督對話生成。

一旦對話出現錯誤,人類員工就會插手對文本進行修正。

儘管確實還需要人力,但這比聘請科學、醫學和商業方面的專家來撰寫文本要便宜得多。

那麼,什麼樣的大模型會用到這些合成數據呢?

微軟研究院最近有研究表明,合成數據可以用於訓練比GPT-4或PaLM-2稍微小一點的語言模型。

以用GPT-4生成的一個“四歲兒童小說”數據集TinyStories為例,這個數據集被證明雖然只包含4歲小孩能理解的單詞,但用於訓練一個大模型之後,同樣可以生成語法正確、閱讀體驗流暢的故事:

對於使用合成數據的理由,Cohere的CEO Aidan Gomez認為:

能從網上獲取數據當然更好,但網絡數據太雜亂了,完全無法滿足需求。相比之下,合成數據已經非常多了,即使它還沒被廣泛傳播。

背後產業鏈已出現

目前,包括Scale AI、Gretel.ai等企業,已經開始給外界提供合成數據服務。

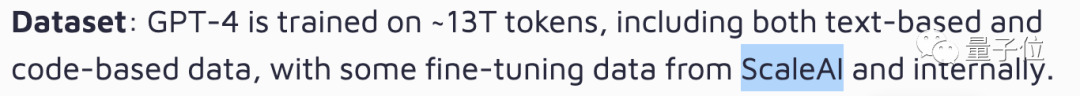

先是Scale AI,旗下就推出了一款合成數據產品Scale Synthetic,用於給企業提供合成數據服務。

而在之前一篇SemiAnalysis爆料GPT-4“大花邊”的新聞中,還提到GPT-4的數據集中,有數百萬行是來自Scale AI和內部的指令微調數據。

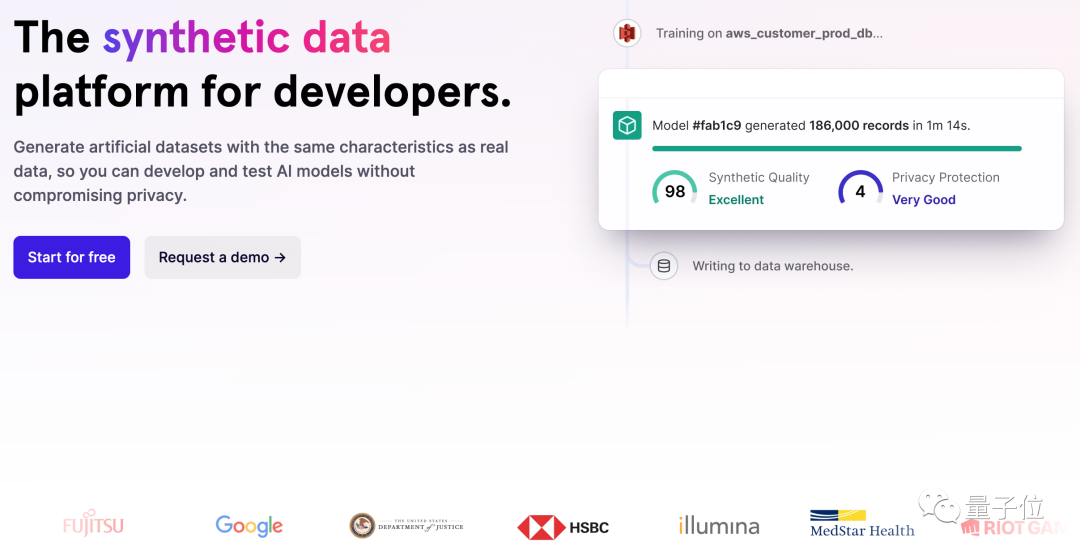

至於合成數據平台Gretel.ai,從官網來看,它已經和谷歌、拳頭遊戲、滙豐銀行等不同企業進行了合作,以生成更多合成的數據提供給其他開發者使用。

Gretel.ai的CEO Ali Golshan認為,合成數據的好處在於,它保留了數據集中所有個人的隱私,同時仍然保持其統計學意義上的完整性(statistical integrity)。

但並非所有人都接受合成數據這種“神奇操作”,目前各方的看法主要分成兩波。

一部分贊同使用合成數據。包括Cohere等AI公司在內,有不少搞大模型的企業仍然堅持這一做法,並認為它可能生成更好的AI,甚至從中誕生出“超級智能”。

另一部分則認為,合成數據終將讓AI“自食其果”。

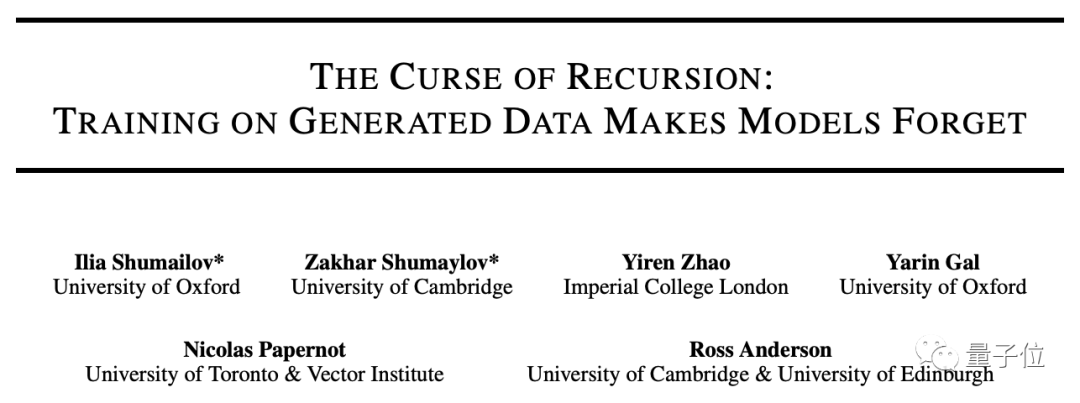

例如一篇來自牛津大學、劍橋大學、帝國理工學院、多倫多大學、愛丁堡大學和Vector Institute多家機構的研究表明:

使用合成數據訓練,會讓模型出現不可逆轉的缺陷:

忘記那些“不可能發生的事件”,最終被自己生成的數據毒害。

有網友認為,這些合成數據最後會變成一灘“無法使用的污泥”——然後人們不得不被迫雇傭數據科學家來對它進行清洗。

還有網友調侃,這聽起來就像是“AI近親繁殖”一樣。

你認為AI需要使用合成數據嗎?

參考鏈接:

[1]https://www.ft.com/content/053ee253-820e-453a-a1d5-0f24985258de

[2]https://the-decoder.com/gpt-4-architecture-datasets-costs-and-more-leaked/

[3]https://arxiv.org/pdf/2306.11644.pdf

[4]https://arxiv.org/pdf/2305.17493v2.pdf